Wie lässt sich Künstliche Intelligenz (KI) (engl. Artificial Intelligence – AI) in der Praxis richtig einsetzen? Der EU AI Act bildet ein zentrales Regelwerk, das die Entwicklung und Nutzung von KI in Europa steuern soll. Ziel des Gesetzes ist es, klare Rahmenbedingungen für Anbieter, Hersteller, Betreiber und Händler sowie Anwender von KI-Modellen und -Systemen zu schaffen und KI zielführend zum Wohle aller zu regulieren.

Im Blogartikel erfahren Sie mehr über den EU AI Act und daraus resultierende Anforderungen für den Einsatz in der Praxis.

Der EU AI Act: Potenziale erschließen und Risiken minimieren

KI bietet zahlreiche Vorteile, wie verbesserte Prozesseffizienz, Innovation und die Bewältigung globaler Herausforderungen und kann verschiedene Arbeitsweisen von Grund auf verändern. Allerdings gibt es auch Risiken. Dazu gehören Diskriminierung, Falschaussagen und Sicherheitsbedrohungen. Der EU AI Act zielt darauf ab, diese Risiken zu minimieren und gleichzeitig die Vorteile der KI zu maximieren.

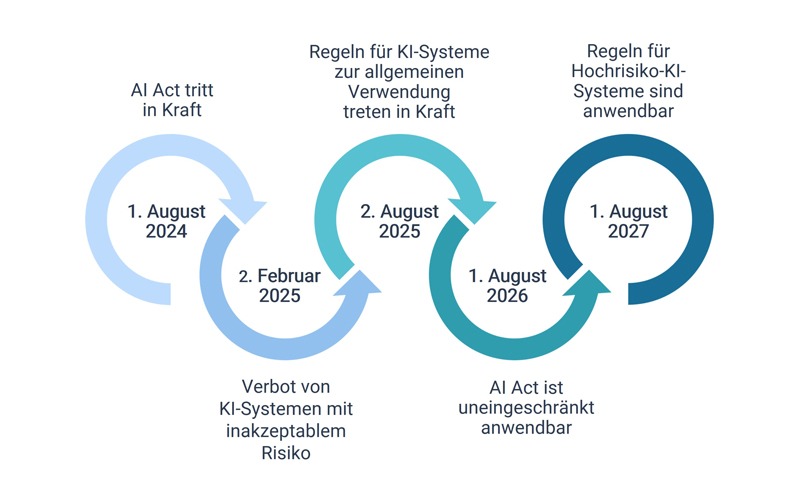

Das Regelwerk EU AI Act trat offiziell am 1. August 2024 in Kraft. Die Anforderungen des Gesetzes werden im Laufe der Zeit allmählich zur Anwendung kommen. So beginnen zum Beispiel zum 2. Februar 2025 Verbote für bestimmte KI-Systeme zu gelten. Bis auf wenige Ausnahmen greift das Gesetz nahezu vollständig ab dem 2. August 2026. Bis zu diesem Datum haben die verschiedenen Akteure Zeit, die Anforderungen zu erfüllen und umzusetzen.

Kategorien von KI-Systemen und Rollen

Nach dem EU AI Act werden KI-Systeme in vier Kategorien eingeteilt.

Verbotene KI:

Laut Artikel 5 EU AI Act handelt es sich bei verbotenen KI-Systemen um Lösungen,…

- die die Entscheidungen von Menschen manipulieren oder ihre Schwachstellen ausnutzen,

- die Menschen auf der Grundlage von biometrischen Daten kategorisieren und diskriminieren,

- die zur sozialen Bewertung von Menschen verwendet werden,

- die zur Echtzeit-Fernidentifizierung im öffentlichen Raum verwendet werden können.

Diese Systeme, stellen ein inakzeptables Risiko dar.

Hochrisiko-KI:

Diese Systeme unterliegen strengen Vorschriften, da sie erhebliche Auswirkungen auf die Sicherheit und Grundrechte haben können. Beispiele bilden KI-basierte medizinische Software und Systeme zur automatisierten Personalrekrutierung.

Begrenztes Risiko:

In diese Kategorie werden Systeme eingeordnet, die leichtere Transparenzanforderungen erfüllen müssen, wie z. B. Chatbots und Deepfakes. Deepfakes sind Inhalte, die so bearbeitet wurden, dass sie täuschend echt wirken und den Eindruck erwecken, authentisch zu sein. Dies schließt die Möglichkeit ein, dass eine Person in einem Video etwas sagt oder tut, was sie tatsächlich nicht gesagt oder getan hat. Der EU AI Act klassifiziert Deepfakes als Systeme mit begrenztem Risiko, da sie in vielen Fällen nicht automatisch zu schwerwiegenden Schäden führen. Sie sollten dennoch reguliert werden, um Missbrauch zu verhindern.

Minimales Risiko:

Die meisten derzeit auf dem EU-Markt verfügbaren KI-Anwendungen, beispielsweise KI-gestützte Videospiele und Spam-Filter, fallen in diese Kategorie und sind weitgehend .

Im EU AI Act sind außerdem klare Rollen für die verschiedenen Akteure im so genannten „KI-Ökosystem“ definiert. Neben dem Händler und Bereitsteller von KI-Systemen sind vor allem der Anbieter und Betreiber hervorzuheben.

Anbieter gelten als Entwickler von KI-Systemen, die für die Einhaltung der Vorschriften verantwortlich sind. Sie müssen sicherstellen, dass ihre Systeme den gesetzlichen Anforderungen entsprechen.

Betreiber sind natürliche oder juristische Personen, die KI-Systeme in einem professionellen Kontext einsetzen. Ihre Verpflichtungen sind weniger umfangreich als die der Anbieter, aber sie müssen sicherstellen, dass die Systeme sicher und konform genutzt werden.

KI-Anwendungen gesetzeskonform einsetzen

Unternehmen wie Microsoft und SAP treiben die Integration von KI zum Beispiel in Form von Assistenzsystemen, wie Copilot oder Joule stark voran. Sie müssen die Anforderungen des AI Acts erfüllen. Aber auch an Anwender stellt das Gesetz verschiedene Anforderungen. So müssen Unternehmen sicherstellen, dass Mitarbeitende im Umgang von KI-Systemen geschult werden. Zudem gelten Transparenzpflichten. Diese verlangen, dass mit KI generierte Inhalte gekennzeichnet werden.

Ein wichtiger Aspekt ist, dass viele dieser KI-Systeme nur in der jeweiligen Cloudvariante zur Verfügung stehen. Das bringt zusätzliche Datenschutz- und Sicherheitsanforderungen und ggf. Hindernisse mit sich. Als Alternative lassen sich Open Source-basierte KI-Systeme auf dedizierter Infrastruktur entwickeln und betreiben, die auch an Kundenwünsche angepasst werden können.

GISA unterstützt Kunden bei der Vorbereitung und Integration dieser KI-Assistenten und behält dabei immer die gesetzlichen Anforderungen und die Compliance-Richtlinien des Kunden im Auge. Auch die Entwicklung von eigenen KI-Anwendungsfällen im Microsoft Azure und SAP-Umfeld oder auf dedizierter Hardware sind Leistungsbestandteile.

Im Sinne des EU AI Acts ist GISA sowohl Betreiber als auch Anbieter von KI-Systemen und daher mit zahlreichen Anforderungen konfrontiert. Vor allem die Entwicklung und der Betrieb eigener KI-Systeme bzw. von KI-Systemen für Kunden, die mitunter in die Kategorie „Hochrisiko KI“ eingestuft werden, erhöhen die Pflichten für Anbieter enorm.

Um diesen Anforderungen gerecht zu werden, orientiert sich GISA an der ISO 42001. Diese hat die Implementierung eines KI-Managementsystems als Ergebnis. Insgesamt bietet die ISO 42001 einen strukturierten Rahmen für die verantwortungsvolle Nutzung von KI-Technologien, der sowohl den Anbietern als auch den Betreibern hilft, die Herausforderungen und Risiken im Zusammenhang mit der Implementierung von KI zu bewältigen. Durch ein KI-Managementsystem wird die verantwortungsvolle KI-Nutzung sichergestellt. Der Umgang mit ethischen Standards, die Vermeidung von Bias (Verzerrungen durch eine falsche Datenbasis, Diskriminierung oder Voreingenommenheit), Datenschutz, Risikomanagement und die Erfüllung von gesetzlichen Anforderungen werden durch die Einführung der ISO 42001 systematisch erarbeitet und eingehalten.

Fazit

Der EU AI Act bildet einen wichtigen Schritt, um die Entwicklung und Nutzung von KI in Europa zu regulieren. Er fördert Innovation und minimiert Risiken. Für Unternehmen, die KI-Systeme entwickeln und betreiben, schafft er die gesetzliche Grundlage zum sicheren, konformen Einsatz dieser Zukunftstechnologien. Von Bedeutung ist dabei, dass die Vorgaben des EU AI Acts richtig angewendet werden. Und es gilt wiederum auch, Überregulierung zu vermeiden und die Wettbewerbsfähigkeit Europas zu sichern.

Mehr über unsere Lösungen im Bereich Künstliche Intelligenz erfahren Sie hier: KI bei GISA